Diskriminacija u javnom sektoru na temelju algoritamskog donošenja odluka

Diskriminacija u javnom sektoru na temelju algoritamskog donošenja odluka

U sklopu projekta FAIR 9. rujna održana je radionica s braniteljima prava: Diskriminacija u javnom sektoru na temelju algoritamskog donošenja odluka: Rješavanje novih izazova i jačanje temeljnih prava.

Radionica je uživo održana na sveučilištu Vrije u Bruxellesu, a savjetnici pravobranitelja Branka Meić Salie i Mario Burek pratili su je online preko platforme Teams.

Cilj projekta FAIR je podići razinu svijesti o Povelji o temeljnim pravima EU-a, a vodi ga Centar za istraživanje temeljnih prava iz Belgije. Odgovor je na Strategiju za jačanje primjene Povelje o temeljnim pravima u dijelu podizanja svijesti javnosti o Povelji. Cilj je mapirati prepreke primjeni Povelje, podići svijest javnosti i promicanje umrežavanja. U Belgiji se puno više koristi Europska konvencija o ljudskim pravima nego Povelja.

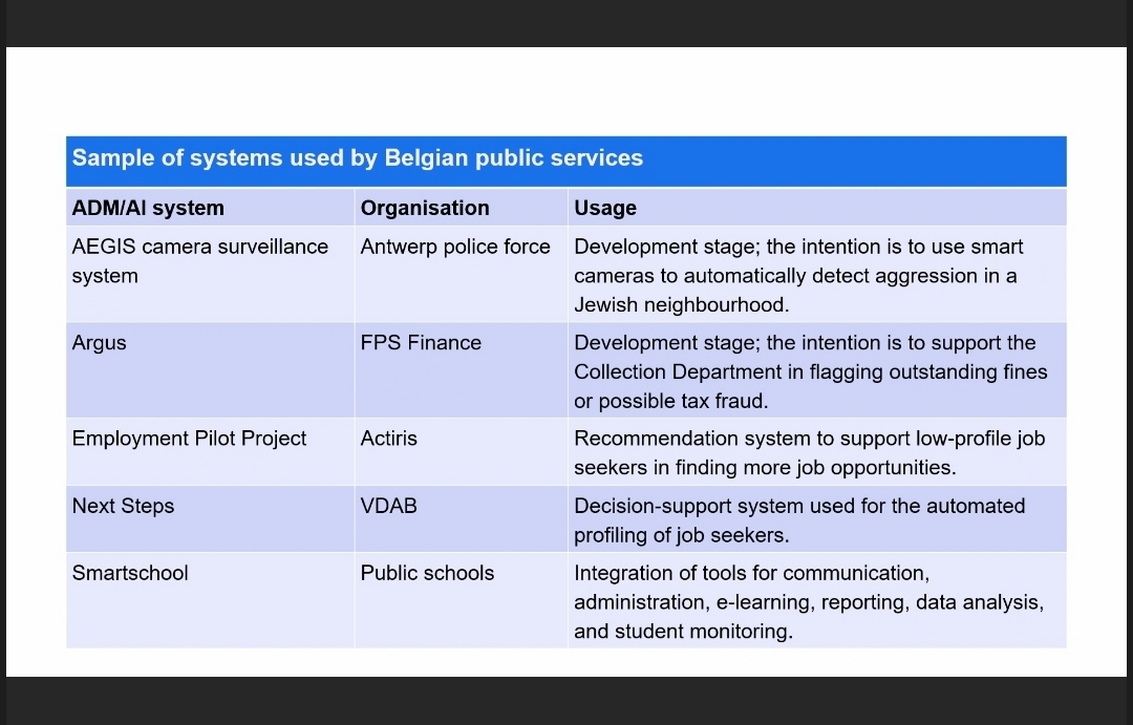

Radionica je započela pitanjem je li diskriminacija ugrađena u dizajn odnosno mogu li algoritmi i sustavi umjetne inteligencije diskriminirati zbog načina na koji su konstruirani prilikom primjene umjetne inteligencije u javnom sektoru. Profesorica sa Sveučilišta Vrije istraživala je kako algoritamski alati u područjima poput policijskih poslova, socijalne skrbi ili službi za zapošljavanje mogu pojačati neizravnu ili strukturnu diskriminaciju. Istraživala je alate koji se veće koriste u javnom sektoru te u kojoj mjeri su usmjereni na zaštitu jednakosti. Velika su ulaganja u korištenje umjetne inteligencije u javnom sektoru. Belgija je donijela plan za razvoj umjetne inteligencije 2022. godine, a donosi se i Zakon o umjetnoj inteligenciji. Teško je reći koliko se koristi umjetna inteligencija jer nema registra. Podaci se dobivaju slanjem upita, ali odgovori nisu pouzdani. Neke zemlje imaju registre iako nema obveze. Često ljudi niti ne prepoznaju da se radi o UI, a ne o automatiziranom donošenju odluka. Bilo bi korisno imati takve registre za nadzor iako ih javnost ne koristi. Neki od sustava za koje je spomenuto da bi mogli zadirati u temeljna prava: sustav video nadzora u židovskim četvrtima, teško je zaključiti radi li se o izrazu agresije, a automatski se poziva policija. Sustavi UI služe kao podrška poreznoj službi za identificiranje nepodmirenih poreza i prijevara povezivanjem više baza podataka. Govorilo se o sustavu kojim se profiliraju tražitelji nisko rangiranih poslova kako bi im se pomoglo u pronalaženju poslova. Došlo se do zaključka da sustavi UI diskriminira migrante, ali u praksi i mišljenje djelatnika ima utjecaj. Međutim, ljudi imaju tendenciju vjerovati računalu. Iako djelatnici mogu odbaciti pogrešne klasifikacije, ponekad se to neće dogoditi.

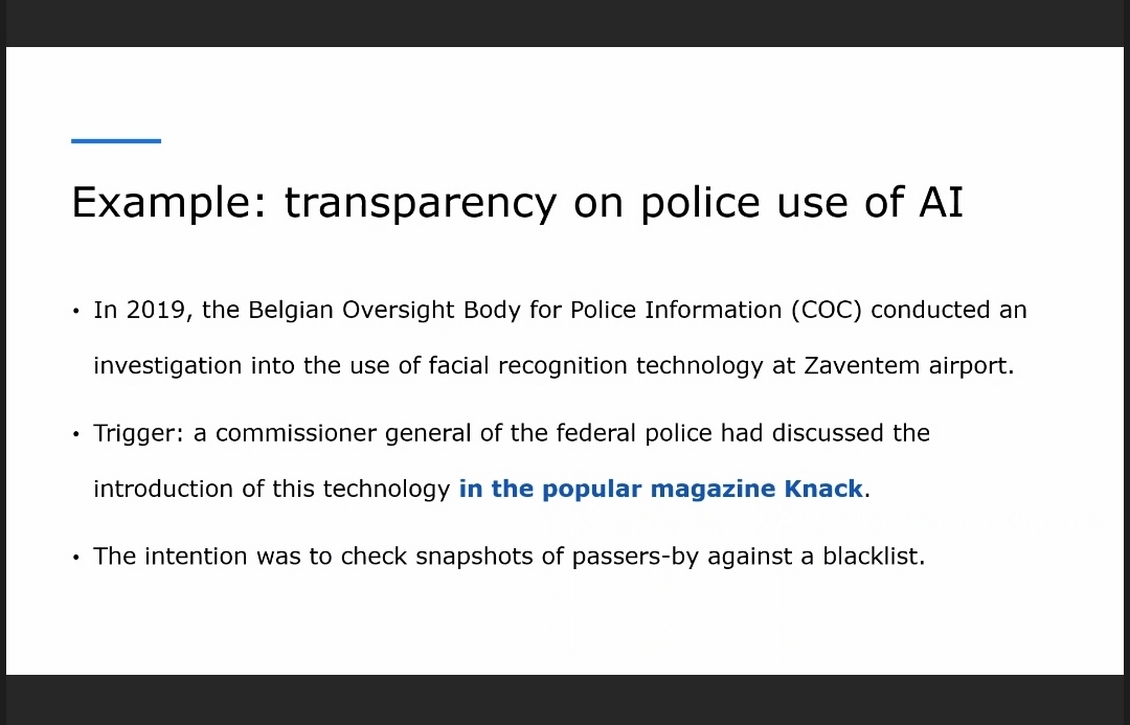

Odluke trebaju biti transparentne i imati demokratski legitimitet, procijeniti utjecaj na temeljna prava. Spomenut je i primjer sustava UI u kojem se koristila tehnologija za prepoznavanje lica na aerodromu. Nije bilo transparentno kako će se koristiti obrada tih podataka. U to vrijeme nije bilo pravnog okvira pa je aktivnost zaustavljena. Potreban je zakon za prepoznavanje lica u realnom vremenu.

Pojedinci bi trebali prijaviti pogrešno korištenje sustava UI, ali imaju ograničenu digitalnu pismenost pogotovo ako dolaze iz ranjivih zajednica. Neće se znati da je korišten alat umjetne inteligencije zbog ograničenog poznavanja sustava umjetne inteligencije. Ako se koristi visoko rizičan sustav UI u obrazovanju, pitanje je hoće li ovlaštene institucije dovoljno dobro poznavati ljudska prava kako bi mogle procijeniti da je došlo do povrede prava.

Rizici za temelja prava uključuju rizike za pravo na jednakost pred zakonom, jednako postupanje prema osobama s invaliditetom, nediskriminaciju. Nedostatak transparentnosti može dovesti do ugrožavanja prava na učinkovit pravni lijek i pravično suđenje, zaštita osobnih podataka i pod-pravo da vas se obavijesti kako se došlo do odluke i je li korišten sustav UI.

Nema prijava o izravnoj diskriminaciji od strane sustava UI, ali je moguće da ima neotkrivenih slučajeva. Primjerice, dolazi do neizravne diskriminacije prilikom automatskog skeniranja parkiranih vozila u svrhu otkrivanja nepropisno parkiranih vozila. Automatski sustav nije bio programiran tako da prepoznaje pravo osoba s invaliditetom na parkiranje pod posebnim uvjetima pa su dobili kazne za nepropisno parkiranje.

Prevelik fokus u nadzoru sustava UI je na privatnosti i osobnim podacima nauštrb jednakosti.

Procjena rizika nejednakog postupanja i diskriminacije je zahtjevna jer nema standardiziranog pristupa niti ideje kako uključiti osobe koje su u riziku od nejednakog postupanja. Oni koji razvijaju sustav ne znaju koji okvir koristiti kako bi spriječili rizike. Teško je uočiti i dokazati diskriminaciju od strane UI na pojedinačnoj razini jer se često ni ne zna je li korišten sustav UI.

Profesorica Cocito s istog Sveučilišta govorila je o ulozi Povelje EU-a o temeljnim pravima vezano uz diskriminaciju u kontekstu algoritamskog donošenja odluka.

U izlaganju je dan pregled glavnih prava na koja može utjecati algoritamsko donošenje odluka, njihove veze s GDPR-om i Zakonom o umjetnoj inteligenciji te praktičan slučaj koji ilustrira kako Povelja može pružiti dodanu vrijednost u rješavanju rizika od diskriminacije.

Europski Akt o umjetnoj inteligenciji zahtijeva da se kod razvoja sustava UI treba provesti procjenu rizika na temeljna prava. Radionica je završena vođenom raspravom strukturiranom oko realističnog scenarija slučaja kako bi se vježbali razumijevanje i reagiranje na rizike diskriminacije. Otvorena su pitanja jesu li se sudionici susreli sa sličnim izazovima u svom radu, koji se oblici diskriminacije pojavljuju xu praksi javnog sektora, koje su prepreke njihovom rješavanju, koji su mehanizmi podrške ili partnerstva potrebni kao i (Ne)trenutna primjena Povelje.